AI 蓬勃发展,液冷热管理需求增长

以 ChatGPT 为主的人工智能生成内容催动算力规模增长,AI崛起直接带动服务器的出货上扬,连带要求散热模组的规格升级,推动散热模组走向液冷方案升级,以满足服务器对散热性和稳定性的严格要求。

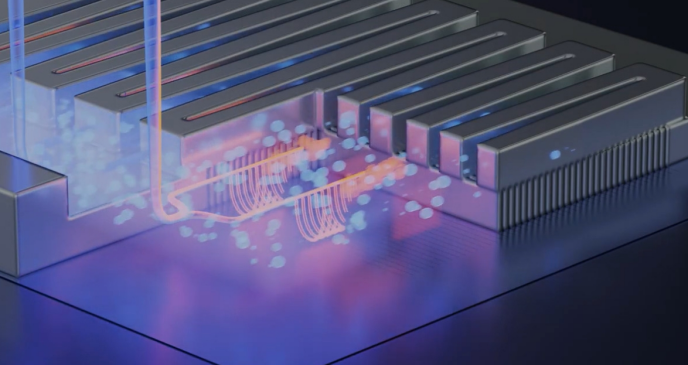

目前散热模组分为气冷散热和液冷散热两种,其中气冷散热就是用空气作为媒介,透过热接口材料、均热片(VC)或热导管等中间材料,由散热片或风扇与空气对流进行散热。而液冷散热则是透过,或浸没式散热,主要就是透过与液体热对流散热,进而使晶片降温,但是随着晶片发热量的增加与体积的缩小,芯片热设计功耗(TDP)的提高,气冷散热逐渐不再使用。

受到AI应用带动相关半导体技术发展,ChatGPT的GPT-3导入就已让AI算法参数量成长到1750亿,使得GPU运算力要成长百倍,目前业界多以液冷中的单相浸没式冷却技术,解决高密度发热的服务器或零件散热问题,但仍有600W的上限值,因为ChatGPT或更高阶的服务器散热能力须高于700W才足以因应。

随着物联网、边缘运算、5G应用的发展,数据AI带动全球算力进入高速成长期,下一代的散热模组设计,主要有两大方向,ㄧ是使用3D均热板(3DVC)升级现有散热模块,二是导入液冷散热系统,改用液体当作热对流介质,提升散热效率,因此2023年液冷测试案量明显增加,但是3DVC终究只是过渡方案,预估2024年到2025年将进入气冷、 液冷并行的时代。

由于新一代服务器TDP提升到接近气冷散热的极限,因此电子科技大厂纷纷开始测试液冷散热,或增加散热空间,像某些企业的TDP 350-400W已达气冷极限,使得液冷散热成为AI芯片主流,像是NVIDA H100的TDP就达700W,气冷采3DVC,普遍需4U以上空间, 并不符合高密度部署架构。

以散热系统占数据中心总耗能约33%来看,减少总用电量降低电力使用效率的方式,包含改善散热系统、信息设备,并使用再生能源,而水的热容量是空气的4倍,因此导入液冷散热系统,液冷板只需要1U的空间,根据测试,若要达到相同算力,液冷所需的机柜量可减少66%、能耗可减少28%、 PUE可由1.6降到1.15,并可提升运算效能。

高速运算导致TDP不断提升,AI服务器对散热的要求大幅提升,传统热导管散热已接近极限,势必需导入液冷散热模组,以目前的产业市况来看,液冷散热导入得比预期快,预估到2024年、2025年将迎来大爆发。

下一篇:没有了